Computecoin Network: Die Infrastruktur von Web 3.0 und dem Metaverse

Zusammenfassung

Web 3.0, eine Weiterentwicklung von Web 2.0, bezeichnet dezentrale Anwendungen (dAPP), die auf der Blockchain laufen. Dies sind Anwendungen, die jedem die Teilnahme ermöglichen, wobei seine persönlichen Daten gut geschützt und von ihm selbst kontrolliert werden. Allerdings gibt es einige Herausforderungen in der Entwicklung von Web 3.0, wie Zugänglichkeit (d.h. geringere Zugänglichkeit für die meisten Benutzer im Vergleich zu modernen Webbrowsern) und Skalierbarkeit (d.h. hohe Kosten und lange Einarbeitungszeit für die Nutzung dezentraler Infrastruktur).

Analyse: Der Übergang von Web 2.0 zu Web 3.0 stellt einen grundlegenden Wandel dar, wie Anwendungen aufgebaut und genutzt werden, weg von zentralisierter Kontrolle hin zu dezentralem Eigentum und dezentraler Steuerung.

Beispielsweise werden nicht-fungible Token (NFT) zwar auf der Blockchain gespeichert, doch die Inhalte der meisten NFTs verbleiben in zentralisierten Cloud-Diensten wie AWS oder Google Cloud. Dies birgt erhebliche Risiken für die NFT-Vermögenswerte der Nutzer und widerspricht dem Wesen von Web 3.0.

Technische Einsicht: Dies erzeugt einen fundamentalen Widerspruch, bei dem das Eigentum dezentralisiert ist, die Inhaltspeicherung jedoch zentralisiert bleibt - was Nutzer genau den Risiken aussetzt, die Web 3.0 beseitigen soll.

Das Metaversum, erstmals 1992 von Neal Stephenson vorgeschlagen, bezeichnet ein unendlich weitläufiges Geflecht persistenter virtueller Welten, in denen Menschen frei reisen, sozialisieren und arbeiten können. Allerdings sehen Metaversum-Anwendungen und Plattformen wie Fortnite und Roblox sich mit einer enormen Herausforderung konfrontiert: Ihr Wachstum wird durch das begrenzte Angebot an kostengünstiger und sofort verfügbarer Rechenleistung aus zentralisierten Clouds eingeschränkt.

Technische Einblicke: Das Metaverse erfordert Rechenressourcen, die exponentiell mit der Nutzerbeteiligung skalieren, was Infrastrukturanforderungen schafft, die traditionelle Cloud-Anbieter nur schwer effizient erfüllen können.

Zusammenfassend lässt sich sagen, dass die Entwicklung von Anwendungen der nächsten Generation auf der aktuellen zentralisierten Infrastruktur (seit den 1990er Jahren aufgebaut) zum Engpass auf dem kritischen Pfad in Richtung unserer Traumwelt geworden ist.

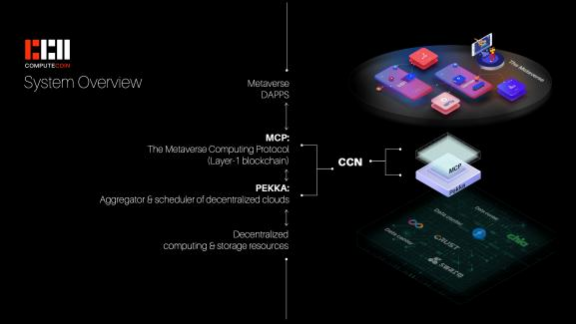

Wir haben dieses Projekt, das Computecoin-Netzwerk zusammen mit seinem nativen Token CCN, initiiert, um dieses Problem zu lösen. Unser Ziel ist es, die Infrastruktur der nächsten Generation für Allzweck-Anwendungen auf Web3 und im Metaverse aufzubauen. Mit anderen Worten: Wir streben danach, für Web 3.0 und das Metaverse das zu leisten, was zentralisierte Cloud-Anbieter für Web 2.0 getan haben.

Strategische Vision: Computecoin strebt danach, die grundlegende Infrastrukturschicht für das gesamte Web 3.0-Ökosystem zu werden, ähnlich wie AWS zum Rückgrat von Web 2.0-Anwendungen wurde.

Der grundlegende Ansatz unseres Systems besteht darin, zunächst dezentrale Clouds wie Filecoin und Rechenzentren weltweit zu bündeln (anstatt wie AWS vor 20 Jahren neue Infrastruktur aufzubauen) und dann Rechenleistung an ein Nähe-Netzwerk der nahegelegenen gebündelten dezentralen Clouds auszulagern, um Datenverarbeitungsaufgaben der Endnutzer wie AR/VR-3D-Rendering und Echtzeit-Datenspeicherung kostengünstig und sofort zu ermöglichen.

Architektur-Hinweis: Dieser Ansatz repräsentiert ein Hybridmodell, das bestehende dezentrale Infrastruktur nutzt und gleichzeitig die Leistung durch nähebasiertes Rechen-Offloading optimiert.

Das Computecoin-Netzwerk besteht aus zwei Ebenen: PEKKA und dem Metaverse Computing Protocol (MCP). PEKKA ist ein Aggregator und Scheduler, der dezentrale Clouds nahtlos integriert und Rechenleistung dynamisch an ein Nähe-Netzwerk auslagert. Zu den Fähigkeiten von PEKKA gehört die Bereitstellung von Web3- und Metaverse-Anwendungen auf dezentralen Clouds innerhalb weniger Minuten sowie die Bereitstellung einer einheitlichen API für einfache Datenspeicherung und -abfrage von jeder dezentralen Cloud wie Filecoin oder Crust.

Technische Innovation: PEKKA löst das Fragmentierungsproblem im dezentralen Computing durch die Bereitstellung einer einheitlichen Schnittstelle, ähnlich wie Cloud-Management-Plattformen die Infrastrukturkomplexität im traditionellen Cloud Computing abstrahiert haben.

Das MCP ist eine Layer-0.5/Layer-1-Blockchain mit einem originellen Konsensalgorithmus, Proof of Honesty (PoH), der garantiert, dass die Ergebnisse ausgelagerter Berechnungen im dezentralen Cloud-Netzwerk authentisch sind. Mit anderen Worten: PoH etabliert Vertrauen in Rechenaufgaben, die an vertrauenslose dezentrale Clouds ausgelagert werden, und legt so das Fundament für das Web-3.0- und Metaverse-Ökosystem.

Sicherheitsinnovation: Proof of Honesty stellt einen neuartigen Ansatz für dezentrales Vertrauen dar, der speziell für die Berechnungsverifizierung entwickelt wurde und nicht nur für die Transaktionsvalidierung.

I. EINLEITUNG

Es herrscht weitgehend Einigkeit darüber, dass Web 3.0 der Schlüssel zur Verwirklichung einer dezentraleren und interaktiveren Erfahrung im Metaverse ist. Folglich betrachten wir Web 3.0 und verwandte Technologien üblicherweise als die Bausteine für das Metaverse. Daher konzentrieren wir uns im Folgenden auf die Diskussion des Metaverse, das ultimative Ziel, das computecoin anstrebt.

A. Einführung in das Metaverse

Stellen Sie sich vor, dass jede Aktivität und jedes Erlebnis in Ihrem täglichen Leben in unmittelbarer Reichweite voneinander stattfindet. Stellen Sie sich nahtlose Übergänge zwischen jedem Raum, jedem Knotenpunkt vor, den Sie bewohnen, sowie den Menschen und Dingen, mit denen Sie darin interagieren. Diese Vision reinster Konnektivität bildet das schlagende Herz des Metaverse.

Der Metaverse, wie der Name schon sagt, bezieht sich auf eine unendlich weite Flickendecke persistenter virtueller Welten, zwischen denen Menschen frei reisen können. Neal Stephenson wird oft zugeschrieben, die erste Beschreibung des Metaverse in seinem wegweisenden Science-Fiction-Roman von 1992 entworfen zu haben SnowSeitdem haben Dutzende Projekte – von Fortnite und Second Life bis hin zu CryptoKitties und Decentraland – die Menschheit näher an das Metaversum herangeführt.

Historischer Kontext: Das Konzept des Metaversums hat sich von Science-Fiction zur praktischen Umsetzung entwickelt, wobei jede Iteration auf früheren technologischen Fortschritten in virtuellen Welten und digitalen Interaktionen aufbaut.

Sobald es Gestalt annimmt, wird das Metaversum seinen Bewohnern ein Online-Erlebnis bieten, das ebenso reichhaltig ist wie ihr Leben in der physischen Welt und eng damit verbunden. Tatsächlich werden diese mutigen Pioniere sich durch alle erdenklichen Geräte – einschließlich VR-Headsets und 3D-gedruckter Wearables – sowie durch Technologiestandards und Netzwerke wie Blockchain und 5G in das Metaversum vertiefen können. Unterdessen werden das reibungslose Funktionieren und die grenzenlose Erweiterungsfähigkeit des Metaversums von einer dauerhaften Basis an Rechenleistung abhängen.

Die Entwicklung des Metaverse hat einen zweigeteilten Weg eingeschlagen. Einerseits zielen zentralisierte Metaverse-Erfahrungen wie Facebook Horizon und Microsoft Mesh darauf ab, eigenständige Welten zu schaffen, deren Gebiet vollständig innerhalb proprietärer Ökosysteme liegt. Andererseits streben dezentralisierte Projekte danach, ihre Nutzer mit den Werkzeugen auszustatten, um digitale Güter zu erschaffen, auszutauschen und zu besitzen, ihre Daten zu sichern und außerhalb der Grenzen von Unternehmenssystemen zu interagieren.

Industrieanalyse: Diese Zweiteilung spiegelt die grundlegendere Spannung in der Technologie zwischen geschlossenen Plattformen und offenen Ökosystemen wider, mit erheblichen Auswirkungen auf Nutzersouveränität und Innovation.

In beiden Fällen jedoch ist das Metaverse nicht bloß eine Plattform, ein Spiel oder ein soziales Netzwerk; es ist potenziell jede Online-Plattform, jedes Spiel und jedes soziale Netzwerk, das von Menschen weltweit genutzt wird, zusammengebündelt in einer Landschaft virtueller Welten, die keinem einzelnen Nutzer und gleichzeitig jedem Nutzer gehört.

Unserer Ansicht nach besteht das Metaverse aus fünf übereinandergelagerten Ebenen. Die grundlegendste Ebene ist die Infrastruktur – die physischen Technologien, die das Funktionieren des Metaverse unterstützen. Dazu gehören technologische Standards und Innovationen wie 5G- und 6G-Netze, Halbleiter, winzige Sensoren, bekannt als MEMS, und Internet-Rechenzentren (IDCs).

Die nächste Ebene ist die Protokollschicht. Ihre Bestandteile sind Technologien wie Blockchain, Distributed Computing und Edge Computing, die eine effiziente und effektive Rechenleistungsverteilung an Endbenutzer sowie die Souveränität von Einzelpersonen über ihre eigenen Online-Daten gewährleisten.

Menschliche Schnittstellen bilden die dritte Ebene des Metaverse. Dazu gehören Geräte – wie Smartphones, 3D-gedruckte Wearables, Biosensoren, neuronale Schnittstellen sowie AR/VR-fähige Headsets und Brillen – die als unsere Einstiegspunkte in das dienen, was eines Tages ein Kollektiv persistenter Online-Welten sein wird.

Die Erstellungsebene des Metaverse baut auf der menschlichen Schnittstellenschicht auf und besteht aus Top-down-Plattformen und -Umgebungen wie Roblox, Shopify und Wix, die Nutzern Werkzeuge zur Erstellung neuer Dinge bereitstellen sollen.

Schließlich vervollständigt die zuvor erwähnte Erlebnisebene den Metaverse-Stapel und verleiht den funktionierenden Teilen des Metaverse eine soziale, gamifizierte Oberfläche. Die Komponenten der Erlebnisebene reichen von Non-Fungible Tokens (NFTs) über E-Commerce und E-Sports bis hin zu sozialen Medien und Spielen.

Die Summe dieser fünf Schichten bildet das Metaverse, ein agiles, beständiges und vernetztes Patchwork virtueller Welten, die Seite an Seite in einem zusammenhängenden Universum existieren.

Architektonische Erkenntnis: Dieser Schichtenansatz bietet einen umfassenden Rahmen zum Verständnis des komplexen Ökosystems, das zur Unterstützung echter Metaverse-Erfahrungen erforderlich ist.

B. Limitations of the metaverse development

Die heute beliebtesten Online-Welten der Welt, wie Fortnite und Roblox, können die radikale Zugänglichkeit, Konnektivität und Kreativität, die das Metaverse von morgen definieren wird, nicht unterstützen. Metaverse-Plattformen stehen vor einer enormen Herausforderung: Durch ein begrenztes Angebot an Rechenleistung eingeschränkt, sind sie nicht in der Lage, ihren Nutzern ein echtes Metaverse-Erlebnis zu bieten.

Obwohl hochkarätige Projekte – wie Facebooks bevorstehendes Horizon-Projekt und Mesh, Microsofts Vorstoß in die Welt des Holoporting und der virtuellen Zusammenarbeit – die Unterstützung führender Cloud-Dienste haben, werden die virtuellen Welten, die sie Nutzern bieten, immer noch von Bürokratie geprägt, hochgradig zentralisiert und mangelnder Interoperabilität unterliegen.

Roblox zum Beispiel, das über mehr als 42 Millionen tägliche aktive Nutzer verfügt, kann nur wenige hundert gleichzeitige Nutzer in einer einzigen virtuellen Welt unterstützen. Dies ist weit entfernt von der Metaverse-Vision, in der Tausende oder sogar Millionen von Nutzern gleichzeitig im selben virtuellen Raum interagieren.

Technische Einschränkung: Aktuelle Plattformen stoßen auf grundlegende architektonische Beschränkungen, die Skalierungen auf Metaverse-Nutzerzahlen verhindern, was den Bedarf an neuen Infrastrukturansätzen unterstreicht.

Eine weitere Einschränkung sind die hohen Kosten für Rechenleistung. Zentralisierte Cloud-Anbieter verlangen Premium-Preise für die Rechenressourcen, die zum Betrieb von Metaverse-Anwendungen benötigt werden, was kleinen Entwicklern und Startups den Markteintritt erschwert. Dies hemmt Innovation und begrenzt die Vielfalt der im Metaverse verfügbaren Erlebnisse.

Wirtschaftliche Analyse: Die hohe Eintrittsbarriere erzeugt einen Innovationsengpass, bei dem nur gut finanzierte Unternehmen teilnehmen können, was die Vielfalt und Kreativität einschränkt, die für ein lebendiges Metaverse-Ökosystem unerlässlich sind.

Darüber hinaus ist die derzeitige Infrastruktur nicht dafür ausgelegt, die einzigartigen Anforderungen von Metaverse-Anwendungen zu bewältigen. Diese Anwendungen erfordern niedrige Latenzzeiten, hohe Bandbreite und Echtzeitverarbeitungsfähigkeiten, die die Möglichkeiten vieler bestehender Systeme übersteigen. Dies führt zu einer minderwertigen Benutzererfahrung mit Verzögerungen, Pufferung und anderen Leistungsproblemen.

C. Our solution: the computecoin network

Computecoin network ist darauf ausgelegt, diese Einschränkungen zu beheben, indem es eine dezentrale, leistungsstarke Infrastruktur für das Metaverse bereitstellt. Unsere Lösung nutzt die Kraft dezentraler Clouds und Blockchain-Technologie, um eine zugänglichere, skalierbarere und kosteneffizientere Plattform für Metaverse-Anwendungen zu schaffen.

Die zentrale Innovation des Computecoin-Netzwerks ist seine Fähigkeit, Rechenressourcen aus einem globalen Netzwerk dezentraler Clouds und Rechenzentren zu bündeln. Dies ermöglicht es uns, eine praktisch unbegrenzte Menge an Rechenleistung zu einem Bruchteil der Kosten zentraler Anbieter bereitzustellen.

Wirtschaftlicher Vorteil: Durch die Nutzung globaler, unzureichend ausgelasteter Rechenressourcen kann Computecoin im Vergleich zu traditionellen Cloud-Anbietern erhebliche Kosteneinsparungen erzielen und diese an Entwickler und Nutzer weitergeben.

Durch die Auslagerung von Berechnungen an ein lokales Netzwerk nahegelegener dezentraler Clouds können wir Latenzzeiten minimieren und Echtzeitleistung für Metaverse-Anwendungen gewährleisten. Dies ist entscheidend für immersive Erlebnisse wie AR/VR, bei denen bereits minimale Verzögerungen die Illusion der Realität zerstören können.

Die zweischichtige Architektur des Computecoin-Netzwerks – PEKKA und MCP – bietet eine umfassende Lösung für das Metaverse. PEKKA übernimmt die Bündelung und Planung von Rechenressourcen, während MCP durch seinen innovativen Proof of Honesty-Konsensalgorithmus die Sicherheit und Authentizität von Berechnungen gewährleistet.

Architekturdesign: Die Trennung von Ressourcenmanagement (PEKKA) und Vertrauensüberprüfung (MCP) schafft ein robustes System, in dem Leistung und Sicherheit unabhängig voneinander optimiert werden und dennoch synergetisch zusammenwirken.

D. Paper organization

Der weitere Verlauf dieser Arbeit ist wie folgt strukturiert: In Abschnitt II geben wir einen detaillierten Überblick über PEKKA, einschließlich seiner Architektur, Fähigkeiten zur Ressourcenaggregation und Mechanismen für Computation Offloading. Abschnitt III konzentriert sich auf das Metaverse Computing Protocol (MCP), mit einer eingehenden Erläuterung des Proof of Honesty Konsensalgorithmus. Abschnitt IV erörtert, wie KI-gestützte Selbstevolution das Computecoin-Netzwerk kontinuierlich verbessern und an wechselnde Anforderungen anpassen wird. In Abschnitt V beschreiben wir die Tokenomics von CCN, einschließlich Tokenverteilung, Stakeholder-Rechten sowie Mining- und Staking-Mechanismen. Abschnitt VI listet unsere Publikationen zum Computecoin-Netzwerk auf. Abschließend fasst Abschnitt VII die Arbeit mit einer Zusammenfassung unserer Vision und Zukunftspläne zusammen.

II. PEKKA

A. Überblick

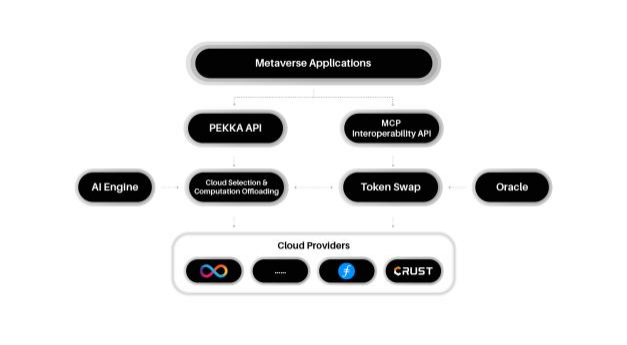

PEKKA (Parallel Edge Computing and Knowledge Aggregator) ist die erste Ebene des Computecoin-Netzwerks. Es fungiert als Aggregator und Scheduler, der dezentrale Clouds nahtlos integriert und Berechnungen dynamisch in ein Näherungsnetzwerk auslagert. Das Hauptziel von PEKKA besteht darin, eine einheitliche Schnittstelle für den Zugriff auf und die Nutzung von Computeressourcen verschiedener dezentraler Cloud-Anbieter bereitzustellen.

PEKKA wurde entwickelt, um die Fragmentierung des dezentralen Cloud-Ökosystems zu adressieren. Derzeit gibt es zahlreiche dezentrale Cloud-Anbieter, die jeweils über eigene APIs, Preismodelle und Ressourcenspezifikationen verfügen. Diese Zersplitterung erschwert es Entwicklern, das gesamte Potenzial dezentralen Rechnens voll auszuschöpfen.

Durch die Bündelung dieser Ressourcen in einem einzigen Netzwerk vereinfacht PEKKA die Bereitstellung und Skalierung von Metaverse-Anwendungen. Entwickler können über eine einheitliche API auf ein globales Netzwerk von Rechenressourcen zugreifen, ohne sich um die zugrunde liegende Infrastruktur kümmern zu müssen.

Developer Experience: PEKKA abstrahiert die Komplexität der Interaktion mit mehreren dezentralen Cloud-Anbietern, ähnlich wie Cloud-Management-Plattformen das Infrastrukturmanagement im traditionellen IT-Bereich vereinfacht haben.

B. Aggregation dezentraler Clouds

PEKKA aggregiert Rechenressourcen von verschiedenen dezentralen Cloud-Anbietern, einschließlich Filecoin, Crust und anderen. Dieser Aggregationsprozess umfasst mehrere wichtige Schritte:

1. Ressourcenermittlung: PEKKA durchsucht kontinuierlich das Netzwerk, um verfügbare Rechenressourcen von verschiedenen Anbietern zu identifizieren. Dies umfasst Informationen über die Art der Ressourcen (CPU, GPU, Speicher), ihren Standort und ihre aktuelle Verfügbarkeit.

Ressourcenvalidierung: Bevor Ressourcen dem Netzwerk hinzugefügt werden, prüft PEKKA deren Leistung und Zuverlässigkeit. Dies stellt sicher, dass nur hochwertige Ressourcen in das Netzwerk aufgenommen werden.

Ressourcenindizierung: Validierte Ressourcen werden in einem Distributed Ledger indexiert, der als transparente und unveränderliche Aufzeichnung aller verfügbaren Ressourcen im Netzwerk dient.

4. Pricing normalization: PEKKA normalisiert die Preisgestaltungsmodelle verschiedener Anbieter, wodurch Benutzer Ressourcen einfach basierend auf ihren Anforderungen und ihrem Budget vergleichen und auswählen können.

5. Dynamic resource allocation: PEKKA überwacht kontinuierlich die Nachfrage nach Rechenressourcen und passt die Zuteilung entsprechend an. Dies stellt sicher, dass Ressourcen effizient genutzt werden und Benutzer Zugriff auf die benötigten Ressourcen haben, wenn sie diese benötigen.

The aggregation process is designed to be decentralized and trustless. No single entity controls the network, and all decisions are made through a consensus mechanism. This ensures that the network remains open, transparent, and resilient.

Ressourcenmanagement: Dieser mehrstufige Aggregationsprozess schafft einen dynamischen Marktplatz für Computerressourcen, der sowohl Angebot (Ressourcenanbieter) als auch Nachfrage (Anwendungsentwickler) durch intelligente Matching-Algorithmen optimiert.

C. Computation offloading to a proximity network

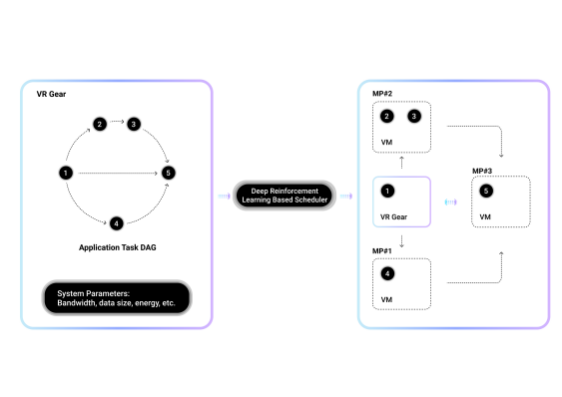

Ein Hauptmerkmal von PEKKA ist die Fähigkeit, Berechnungen an ein Näherungsnetzwerk benachbarter dezentraler Clouds auszulagern. Dies ist entscheidend für Metaverse-Anwendungen, die geringe Latenzzeiten und Echtzeitverarbeitung erfordern.

Beim Rechenoffloading werden Berechnungsaufgaben vom Endgerät des Nutzers an einen nahegelegenen Knotenpunkt im Netzwerk übertragen. Dies verringert die Belastung des Nutzergeräts und gewährleistet eine schnelle sowie effiziente Aufgabenverarbeitung.

PEKKA nutzt einen ausgeklügelten Algorithmus, um den optimalen Knotenpunkt für jede Aufgabe zu bestimmen. Dieser Algorithmus berücksichtigt mehrere Faktoren, darunter die Nähe des Knotens zum Nutzer, seine aktuelle Auslastung, seine Leistungsfähigkeit und die Nutzungskosten.

Der Offloading-Prozess ist für den Benutzer und den Anwendungsentwickler transparent. Sobald eine Aufgabe ausgelagert wird, überwacht PEKKA deren Fortschritt und stellt sicher, dass die Ergebnisse dem Benutzer rechtzeitig zurückgegeben werden.

Leistungsoptimierung: Näherungsbasiertes Computation Offloading ist besonders entscheidend für latenzsensitive Anwendungen wie AR/VR, bei denen selbst Millisekunden Verzögerung die Benutzererfahrung erheblich beeinträchtigen können.

C1. Offloading function 1

Die erste Offloading-Funktion ist für latenzempfindliche Aufgaben konzipiert, wie Echtzeit-Rendering und interaktive Anwendungen. Für diese Aufgaben priorisiert PEKKA Nähe und Geschwindigkeit über Kosten.

Der Algorithmus funktioniert wie folgt: Wenn eine latenzempfindliche Aufgabe empfangen wird, identifiziert PEKKA alle Knoten innerhalb eines bestimmten geografischen Radius des Nutzers. Anschließend bewertet es diese Knoten basierend auf ihrer aktuellen Auslastung und Verarbeitungskapazität. Der Knoten mit der niedrigsten Latenz und ausreichender Kapazität wird zur Aufgabenbearbeitung ausgewählt.

Um Latenz weiter zu minimieren, nutzt PEKKA Predictive Analytics zur Prognose zukünftiger Nachfrage. Dies ermöglicht dem Netzwerk, Ressourcen in Gebieten mit voraussichtlich hoher Nachfrage vorab zu positionieren und so stets niedrige Latenzzeiten bei der Verarbeitung sicherzustellen.

Predictive Intelligence: Der Einsatz von Predictive Analytics stellt einen anspruchsvollen Ansatz im Ressourcenmanagement dar, der über reaktive Zuteilung hinausgeht und auf proaktiver Optimierung basierend auf Nutzungsmustern und Trends beruht.

C2. Offloading function 2

Die zweite Offloading-Funktion ist für Batch-Processing-Aufgaben konzipiert, wie Datenanalyse und Content-Rendering. Bei diesen Aufgaben priorisiert PEKKA Kosten und Effizienz über Geschwindigkeit.

Der Algorithmus funktioniert wie folgt: Wenn eine Stapelverarbeitungsaufgabe empfangen wird, identifiziert PEKKA alle Knoten im Netzwerk mit den notwendigen Ressourcen zur Aufgabenbearbeitung. Anschließend bewertet es diese Knoten basierend auf Kosten, Verfügbarkeit und historischer Leistung. Der Knoten mit der besten Kombination aus Kosten und Effizienz wird zur Aufgabenbearbeitung ausgewählt.

Für große Stapelverarbeitungsaufgaben kann PEKKA die Aufgabe in kleinere Teilaufgaben splitten und diese auf mehrere Knoten verteilen. Dieser Parallelverarbeitungsansatz reduziert die für große Aufgaben benötigte Zeit erheblich.

Workload-Optimierung: Dieser duale Funktionsansatz ermöglicht es PEKKA, verschiedene Arten von Rechenlasten zu optimieren und gewährleistet sowohl Echtzeit-Reaktionsfähigkeit für interaktive Anwendungen als auch Kosteneffizienz für Hintergrundverarbeitungsaufgaben.

III. Metaverse Computing Protocol

A. Überblick

The Metaverse Computing Protocol (MCP) ist die zweite Ebene des Computecoin-Netzwerks. Es handelt sich um eine Layer-0.5/Layer-1-Blockchain, die die Sicherheits- und Vertrauensinfrastruktur für das Netzwerk bereitstellt. MCP wurde entwickelt, um sicherzustellen, dass die Ergebnisse von Berechnungen im dezentralen Cloud-Netzwerk authentisch und zuverlässig sind.

Eine der größten Herausforderungen im dezentralen Computing besteht darin, sicherzustellen, dass Knoten Berechnungen korrekt und ehrlich ausführen. In einer vertrauenslosen Umgebung gibt es keine Garantie, dass ein Knoten die Ergebnisse einer Berechnung nicht manipuliert oder behauptet, Arbeit geleistet zu haben, die er nicht ausgeführt hat.

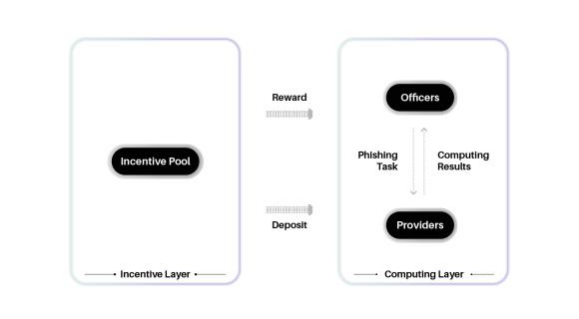

MCP begegnet dieser Herausforderung durch seinen innovativen Proof of Honesty (PoH)-Konsensalgorithmus. PoH wurde entwickelt, um Knoten zu ehrlichem Verhalten zu incentivieren und bösartig handelnde Knoten zu erkennen und zu bestrafen.

Neben der Bereitstellung von Sicherheit und Vertrauen regelt MCP auch die wirtschaftlichen Aspekte des Netzwerks. Es verwaltet die Erstellung und Verteilung von CCN-Tokens, die zur Bezahlung von Rechenressourcen und zur Belohnung von Knoten für ihre Beiträge zum Netzwerk verwendet werden.

Vertrauensarchitektur: MCP löst das grundlegende Vertrauensproblem im dezentralen Computing durch ein System, in dem ehrliches Verhalten wirtschaftlich belohnt und unehrliches Verhalten wirtschaftlich bestraft wird.

B. Consensus: Proof of Honesty (PoH)

Proof of Honesty (PoH) ist ein neuartiger Konsensalgorithmus, der speziell für das Computecoin-Netzwerk entwickelt wurde. Im Gegensatz zu traditionellen Konsensalgorithmen wie Proof of Work (PoW) und Proof of Stake (PoS), die sich auf die Validierung von Transaktionen konzentrieren, ist PoH zur Validierung von Berechnungsergebnissen konzipiert.

Die Kernidee hinter PoH ist die Schaffung eines Systems, in dem Knoten Anreize erhalten, ehrlich zu handeln. Knoten, die konsequent genaue Ergebnisse liefern, werden mit CCN-Token belohnt, während Knoten mit ungenauen Ergebnissen bestraft werden.

PoH funktioniert durch periodisches Senden von "Phishing-Aufgaben" an Knoten im Netzwerk. Diese Aufgaben dienen dazu, die Ehrlichkeit der Knoten zu testen. Knoten, die diese Aufgaben korrekt abschließen, demonstrieren ihre Ehrlichkeit und werden belohnt. Knoten, die diese Aufgaben nicht erfüllen oder falsche Ergebnisse liefern, werden bestraft.

Algorithmus-Innovation: PoH stellt einen bedeutenden Bruch mit traditionellen Konsensmechanismen dar, indem es sich auf rechnerische Integrität konzentriert anstatt nur auf Transaktionsvalidierung, was es besonders geeignet für dezentrale Rechennetzwerke macht.

B1. Algorithm overview

Der PoH-Algorithmus besteht aus mehreren Schlüsselkomponenten: dem Phishing-Aufgaben-Repository, dem Aufgabenplaner, dem Ergebnissprüfer, dem Beurteilungssystem und dem Anreizprotokoll.

Der Algorithmus funktioniert wie folgt: Der Task-Scheduler wählt Knotenpunkte aus dem Netzwerk aus, um Rechenaufgaben durchzuführen. Diese Aufgaben umfassen sowohl echte Nutzeraufgaben als auch Phishing-Tasks aus dem Phishing-Task-Repository. Die Knotenpunkte verarbeiten diese Aufgaben und übermitteln die Ergebnisse an den Result Verifier.

Der Result Verifier überprüft die Ergebnisse sowohl echter Aufgaben als auch von Phishing-Tasks. Bei echten Aufgaben verwendet der Verifier eine Kombination aus kryptografischen Techniken und Kreuzvalidierungen mit anderen Knotenpunkten, um die Genauigkeit sicherzustellen. Bei Phishing-Tasks kennt der Verifier das korrekte Ergebnis bereits und kann sofort erkennen, ob ein Knotenpunkt ein falsches Ergebnis geliefert hat.

Das Urteilssystem nutzt die Ergebnisse des Verifiers, um zu bestimmen, welche Knoten ehrlich handeln und welche nicht. Knoten, die konsequent korrekte Ergebnisse liefern, werden mit CCN-Token belohnt, während Knoten, die falsche Ergebnisse liefern, durch Einbehaltung ihres Einsatzes bestraft werden.

Im Laufe der Zeit passt sich der Algorithmus an das Verhalten der Knoten an. Knoten mit einer Historie von Ehrlichkeit werden mit wichtigeren Aufgaben betraut und erhalten höhere Belohnungen. Knoten mit einer Historie von Unehrlichkeit erhalten weniger Aufgaben und können schließlich vom Netzwerk ausgeschlossen werden.

Adaptives Vertrauen: Das reputationsbasierte System schafft einen sich selbst verstärkenden Kreislauf, in dem ehrliche Knoten mehr Möglichkeiten und höhere Belohnungen erhalten, während unehrliche Knoten schrittweise vom Netzwerk ausgegrenzt werden.

B2. Phishing-task repository

Das Phishing-task repository ist eine Sammlung vorberechneter Aufgaben mit bekannten Ergebnissen. Diese Aufgaben sind dazu konzipiert, die Ehrlichkeit und Kompetenz der Knoten im Netzwerk zu testen.

Das Repository enthält eine Vielzahl unterschiedlicher Aufgaben, darunter einfache Berechnungen, komplexe Simulationen und Datenverarbeitungsaufgaben. Die Aufgaben sind repräsentativ für die Aufgabentypen, denen Knoten im realen Netzwerk begegnen werden.

Um sicherzustellen, dass Knoten Phishing-Aufgaben nicht von echten Aufgaben unterscheiden können, sind Phishing-Aufgaben identisch zu echten Aufgaben formatiert. Sie decken ebenfalls ein ähnliches Spektrum an Schwierigkeitsgraden und Rechenanforderungen ab.

Das Repository wird kontinuierlich mit neuen Aufgaben aktualisiert, um zu verhindern, dass Knoten die Ergebnisse bestehender Aufgaben auswendig lernen. Neue Aufgaben werden von einer dezentralen Gruppe von Validatoren hinzugefügt, die für ihre Beiträge mit CCN-Token belohnt werden.

Die Auswahl von Aufgaben aus dem Repository erfolgt zufällig, um sicherzustellen, dass Knoten nicht vorhersagen können, welche Aufgaben Phishing-Aufgaben sein werden. Dieser zufällige Auswahlprozess soll es bösartigen Knoten erschweren, das System zu manipulieren.

Sicherheitsdesign: Der Phishing-Task-Mechanismus schafft ein kontinuierliches Verifizierungssystem, das transparent im normalen Workflow arbeitet und es böswilligen Akteuren erschwert, den Verifizierungsprozess zu erkennen und zu umgehen.

B3. Task scheduler

Der Task-Scheduler ist für die Verteilung von Aufgaben an Knoten im Netzwerk verantwortlich. Er spielt eine entscheidende Rolle dabei, sicherzustellen, dass Aufgaben effizient verarbeitet werden und das Netzwerk sicher bleibt.

Der Scheduler verwendet ein Reputationssystem, um zu bestimmen, welche Knoten für den Empfang von Aufgaben berechtigt sind. Knoten mit einer höheren Reputation (d.h. einer Historie korrekter Ergebnisse) erhalten mit höherer Wahrscheinlichkeit Aufgaben, insbesondere hochwertige Aufgaben.

Bei der Aufgabenverteilung berücksichtigt der Scheduler mehrere Faktoren, darunter die Reputation des Knotens, seine Verarbeitungskapazitäten, seinen Standort und seine aktuelle Auslastung. Dies stellt sicher, dass Aufgaben den am besten geeigneten Knoten zugewiesen werden.

Bei Aufgaben echter Benutzer kann der Scheduler dieselbe Aufgabe mehreren Knoten zuweisen, um Kreuzvalidierung zu ermöglichen. Dies hilft sicherzustellen, dass die Ergebnisse genau sind, selbst wenn einige Knoten böswillig handeln.

Bei Phishing-Aufgaben weist der Scheduler jede Aufgabe typischerweise einem einzelnen Knoten zu. Dies liegt daran, dass das korrekte Ergebnis bereits bekannt ist, sodass keine Kreuzvalidierung erforderlich ist.

Der Scheduler überwacht kontinuierlich die Leistung der Knoten und passt seinen Taskverteilungsalgorithmus entsprechend an. Dies gewährleistet, dass das Netzwerk effizient und reaktionsfähig auf sich ändernde Bedingungen bleibt.

Intelligente Verteilung: Der mehrfaktorielle Entscheidungsprozess des Schedulers optimiert sowohl die Leistung (durch Fähigkeits- und Standortabgleich) als auch die Sicherheit (durch reputationsbasierte Taskzuweisung).

B4. Result verification

Die Ergebniskontrollkomponente ist für die Überprüfung der Genauigkeit der von Knoten zurückgegebenen Ergebnisse verantwortlich. Sie verwendet eine Kombination von Techniken, um sicherzustellen, dass die Ergebnisse sowohl korrekt als auch authentisch sind.

Bei Phishing-Aufgaben ist die Verifizierung unkompliziert: Der Verifizierer vergleicht einfach das vom Knoten zurückgegebene Ergebnis mit dem bekannten korrekten Ergebnis. Wenn sie übereinstimmen, gilt der Knoten als ehrlich. Wenn sie nicht übereinstimmen, gilt der Knoten als unehrlich.

Bei realen Benutzeraufgaben ist die Verifizierung komplexer. Der Verifizierer verwendet mehrere Techniken, darunter:

1. Cross-validation: Wenn dieselbe Aufgabe mehreren Knoten zugewiesen wird, vergleicht der Verifizierer die Ergebnisse. Besteht ein Konsens zwischen den Knoten, gilt das Ergebnis als korrekt. Bei Abweichungen kann der Verifizierer zusätzliche Knoten zur Aufgabenbearbeitung anfordern, um die Diskrepanz zu klären.

2. Cryptographic verification: Einige Aufgaben enthalten kryptografische Nachweise, die es dem Verifizierer ermöglichen, die Richtigkeit des Ergebnisses zu überprüfen, ohne die gesamte Aufgabe neu zu verarbeiten. Dies ist besonders nützlich bei komplexen Aufgaben, deren Neuberechnung hohe Kosten verursachen würde.

3. Spot checking: Der Verifizierer wählt zufällig einen Teil der realen Aufgaben aus, um diese selbst erneut zu verarbeiten. Dies trägt dazu bei, sicherzustellen, dass Knoten nicht kontinuierlich fehlerhafte Ergebnisse für echte Aufgaben liefern können, ohne entdeckt zu werden.

Der Verifizierungsprozess ist darauf ausgelegt, effizient zu sein, sodass er dem Netzwerk keinen signifikanten Overhead hinzufügt. Das Ziel ist es, ein hohes Maß an Sicherheit zu bieten und gleichzeitig die Leistung und Skalierbarkeit des Netzwerks aufrechtzuerhalten.

Verification Strategy: Der mehrschichtige Verifizierungsansatz bietet robuste Sicherheit, während der Rechenaufwand minimiert wird, und schafft so ein Gleichgewicht zwischen Vertrauen und Leistung, das für praktisches dezentrales Computing unerlässlich ist.

B5. Judgement

Das Bewertungssystem ist für die Beurteilung des Verhaltens von Knotenpunkten auf Basis der Ergebnisse des Verifizierungsprozesses verantwortlich. Es weist jedem Knotenpunkt einen Reputationsscore zu, der die Historie der Ehrlichkeit und Zuverlässigkeit des Knotens widerspiegelt.

Knoten, die durchgängig korrekte Ergebnisse liefern, verzeichnen einen Anstieg ihres Reputationsscores. Knoten mit fehlerhaften Ergebnissen erfahren eine Verringerung ihres Reputationsscores. Das Ausmaß der Veränderung hängt vom Schweregrad des Verstoßes ab.

Bei geringfügigen Verstößen, wie gelegentlich falschen Ergebnissen, kann der Reputationswert leicht sinken. Bei schwerwiegenderen Verstößen, wie der konsequenten Lieferung falscher Ergebnisse oder Versuchen, das System zu manipulieren, kann der Reputationswert erheblich sinken.

Zusätzlich zur Anpassung der Reputationswerte kann das Sanktionssystem auch andere Strafen verhängen. Beispielsweise können Knoten mit sehr niedrigen Reputationswerten vorübergehend oder dauerhaft vom Netzwerk ausgeschlossen werden. Ihnen können auch die hinterlegten CCN-Tokens beschlagnahmt werden.

Das Urteilssystem ist darauf ausgelegt, transparent und fair zu sein. Die Regeln zur Bewertung des Knotenverhaltens sind öffentlich einsehbar, und die Entscheidungen des Systems basieren auf objektiven Kriterien.

Reputation Economics: Das Reputationssystem schafft einen starken wirtschaftlichen Anreiz für ehrliches Verhalten, da Knoten mit hohen Reputationswerten mehr Aufgaben und höhere Belohnungen erhalten, was einen positiven Kreislauf aus Vertrauen und Leistung erzeugt.

B6. Incentive protocol

Das Anreizprotokoll ist darauf ausgelegt, Knoten zu belohnen, die sich ehrlich verhalten und zum Netzwerk beitragen. Es nutzt eine Kombination aus Blockbelohnungen, Transaktionsgebühren und Aufgabenabschlussprämien, um erwünschtes Verhalten zu incentivieren.

Blockbelohnungen werden an Knoten ausgezahlt, die Transaktionen erfolgreich validieren und neue Blöcke in der MCP-Blockchain erstellen. Die Höhe der Belohnung wird durch den Inflationsplan des Netzwerks bestimmt.

Transaktionsgebühren werden von Nutzern gezahlt, um ihre Transaktionen in der Blockchain aufnehmen zu lassen. Diese Gebühren werden an die Knoten verteilt, die die Transaktionen validieren.

Aufgabenabschlussprämien werden an Knotenpunkte ausgezahlt, die Rechenaufgaben erfolgreich abschließen. Die Höhe der Belohnung hängt von der Komplexität der Aufgabe, dem Ruf des Knotenpunkts und der aktuellen Nachfrage nach Rechenressourcen ab.

Knotenpunkte mit höheren Reputationswerten erhalten höhere Belohnungen für das Abschließen von Aufgaben. Dies erzeugt eine positive Rückkopplungsschleife, bei der ehrliches Verhalten belohnt wird und Knotenpunkte Anreize haben, einen guten Ruf zu bewahren.

Zusätzlich zu diesen Belohnungen umfasst das Anreizprotokoll auch Mechanismen zur Verhinderung böswilligen Verhaltens. Beispielsweise müssen Nodes CCN-Token als Sicherheit hinterlegen, um am Netzwerk teilzunehmen. Wenn festgestellt wird, dass sich ein Node böswillig verhält, kann seine Sicherheit beschlagnahmt werden.

Die Kombination aus Belohnungen und Strafen schafft einen starken Anreiz für Nodes, sich ehrlich zu verhalten und zum Erfolg des Netzwerks beizutragen.

Economic Design: Das Anreizprotokoll schafft ein ausgewogenes Wirtschaftssystem, das Beiträge belohnt und gleichzeitig böswilliges Verhalten bestraft, wodurch die Anreize einzelner Nodes mit der allgemeinen Gesundheit und Sicherheit des Netzwerks in Einklang gebracht werden.

C. Systemoptimierung

Um sicherzustellen, dass das Computecoin-Netzwerk effizient, skalierbar und reaktionsschnell ist, haben wir mehrere Systemoptimierungstechniken implementiert:

1. Sharding: Die MCP-Blockchain ist in mehrere Shards unterteilt, von denen jeder Transaktionen unabhängig verarbeiten kann. Dies erhöht den Durchsatz des Netzwerks erheblich.

Parallelverarbeitung: Sowohl PEKKA als auch MCP sind für die Nutzung von Parallelverarbeitung konzipiert. Dies ermöglicht dem Netzwerk, mehrere Aufgaben gleichzeitig zu bewältigen und seine Gesamtkapazität zu steigern.

Caching: Häufig abgerufene Daten und Ergebnisse werden zwischengespeichert, um redundante Berechnungen zu reduzieren. Dies verbessert die Leistung des Netzwerks und senkt die Nutzungskosten.

4. Dynamische Ressourcenzuteilung: Das Netzwerk überwacht kontinuierlich die Nachfrage nach Rechenressourcen und passt die Ressourcenzuteilung entsprechend an. Dies gewährleistet eine effiziente Nutzung der Ressourcen und ermöglicht es dem Netzwerk, sich an wechselnde Anforderungen anzupassen.

5. Komprimierung: Daten werden vor der Übertragung über das Netzwerk komprimiert, was den Bandbreitenbedarf reduziert und die Leistung verbessert.

6. Optimierte Algorithmen: Die für Aufgabenplanung, Ergebniskontrolle und Konsensfindung eingesetzten Algorithmen werden kontinuierlich optimiert, um die Effizienz zu steigern und Rechenaufwand zu reduzieren.

Diese Optimierungen stellen sicher, dass das Computecoin-Netzwerk die hohen Anforderungen von Metaverse-Anwendungen bewältigen kann, während gleichzeitig ein hohes Maß an Leistung und Sicherheit gewahrt bleibt.

Performance Engineering: Diese Optimierungen repräsentieren modernste Techniken im Engineering verteilter Systeme und gewährleisten, dass das Netzwerk skalieren kann, um den massiven Rechenanforderungen des Metaverse bei niedriger Latenz und hoher Zuverlässigkeit gerecht zu werden.

IV. KI-GESTÜTZTE SELBSTEVOLUTION

Das Computecoin-Netzwerk ist so konzipiert, dass es sich durch KI-gestützte Selbstevolution kontinuierlich verbessert und an wechselnde Bedingungen anpasst. Diese Fähigkeit ermöglicht es dem Netzwerk, seine Leistung zu optimieren, seine Sicherheit zu erhöhen und seine Funktionalität im Laufe der Zeit zu erweitern.

Im Kern dieser Selbstevolutionsfähigkeit steht ein Netzwerk von KI-Agenten, die verschiedene Aspekte des Netzwerkbetriebs überwachen. Diese Agenten sammeln Daten zur Netzwerkleistung, Knotenverhalten, Nutzernachfrage und anderen relevanten Faktoren.

Mithilfe von Machine-Learning-Algorithmen analysieren diese Agenten die gesammelten Daten, um Muster zu identifizieren, Anomalien zu erkennen und Vorhersagen über das künftige Netzwerkverhalten zu treffen. Basierend auf dieser Analyse können die Agenten Verbesserungen der Netzwerkalgorithmen, -protokolle und Ressourcenzuteilungsstrategien vorschlagen.

Einige Beispiele, wie KI zur Verbesserung des Netzwerks eingesetzt wird, sind:

Predictive Resource Allocation: KI-Algorithmen prognostizieren den künftigen Bedarf an Rechenressourcen und passen die Ressourcenzuteilung entsprechend an. Dadurch wird sichergestellt, dass das Netzwerk während Spitzenzeiten über ausreichende Kapazität verfügt, um die Nachfrage zu decken.

Anomaly Detection: KI-Agenten erkennen ungewöhnliche Verhaltensmuster, die auf bösartige Aktivitäten hindeuten könnten. Dies ermöglicht dem Netzwerk, schnell auf potenzielle Sicherheitsbedrohungen zu reagieren.

Performance Optimization: KI-Algorithmen analysieren Netzwerkleistungsdaten, um Engpässe zu identifizieren und Optimierungen vorzuschlagen. Dies trägt zur kontinuierlichen Verbesserung der Geschwindigkeit und Effizienz des Netzwerks bei.

4. Adaptive Sicherheit: KI-Agenten lernen aus vergangenen Sicherheitsvorfällen, um neue Strategien zum Schutz des Netzwerks zu entwickeln. Dies ermöglicht dem Netzwerk, sich an neue Bedrohungstypen anzupassen, sobald sie auftreten.

5. Personalisierter Service: KI-Algorithmen analysieren das Nutzerverhalten, um personalisierte Empfehlungen bereitzustellen und das Nutzererlebnis zu optimieren.

Technische Perspektive: Die Integration von KI zur Selbstevolution stellt einen bedeutenden Fortschritt in Blockchain- und dezentralen Systemen dar, der eine kontinuierliche Optimierung ohne manuelle Protokoll-Upgrades ermöglicht.

Der Selbstevolutionsprozess ist dezentral und transparent konzipiert. KI-Agenten operieren innerhalb eines Regelwerks, das sicherstellt, dass ihre Empfehlungen mit den übergeordneten Zielen des Netzwerks übereinstimmen. Vorgeschlagene Änderungen am Netzwerk werden von einer dezentralen Gemeinschaft von Validatoren geprüft, bevor sie implementiert werden.

Diese KI-gestützte Selbstevolutionsfähigkeit stellt sicher, dass das Computecoin-Netzwerk technologisch an der Spitze bleibt und sich kontinuierlich an die sich entwickelnden Anforderungen des Metaversums anpasst.

Adaptive Architecture: Diese Selbstevolutionstransformation verwandelt das Netzwerk von einer statischen Infrastruktur in ein lebendiges, adaptives System, das sich kontinuierlich auf Basis realer Nutzungsmuster und neu entstehender Anforderungen optimieren kann.

V. TOKENOMICS

A. CCN Token-Zuteilung

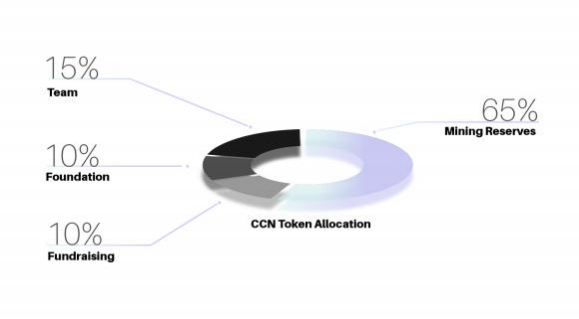

Die Gesamtmenge der CCN-Token ist auf 21 Milliarden festgelegt. Die Token werden wie folgt zugeteilt:

1. Mining-Belohnungen: 50 % (10,5 Milliarden Token) sind für Mining-Belohnungen reserviert. Diese Token werden an Knoten verteilt, die Rechenressourcen zum Netzwerk beisteuern und zur Sicherung der MCP-Blockchain beitragen.

Team und Berater: 15 % (3,15 Milliarden Token) sind für das Gründungsteam und die Berater reserviert. Diese Token unterliegen einem Vesting-Zeitplan, um langfristiges Engagement für das Projekt zu gewährleisten.

Stiftung: 15 % (3,15 Milliarden Token) sind der Computecoin Network Foundation zugeteilt. Diese Token werden zur Finanzierung von Forschung und Entwicklung, Marketing sowie Community-Initiativen verwendet.

Strategische Partner: 10 % (2,1 Milliarden Token) sind strategischen Partnern vorbehalten, die dem Netzwerk wesentliche Ressourcen und Unterstützung bereitstellen.

5. Public sale: 10 % ( 2.1 Milliarden Tokens ) sind für den öffentlichen Verkauf vorgesehen , um Mittel für das Projekt zu beschaffen und die Tokens an die breitere Community zu verteilen .

Die Token-Verteilung ist so konzipiert , dass eine ausgewogene Verteilung der Tokens unter allen Beteiligten gewährleistet ist , wobei der Schwerpunkt besonders auf der Belohnung derjenigen liegt , die zum Wachstum und zur Sicherheit des Netzwerks beitragen .

Economic Design: Die Token-Zuteilungsstrategie balanciert Anreize für frühe Mitwirkende mit langfristigem Ökosystemwachstum und gewährleistet die Ausrichtung aller Beteiligten auf den Netzwerkerfolg.

B. CCN stakeholders and their rights

Es gibt mehrere Arten von Beteiligten im Computecoin-Netzwerk, die jeweils über eigene Rechte und Verantwortlichkeiten verfügen:

1. Miner: Miner stellen dem Netzwerk Rechenressourcen zur Verfügung und tragen zur Absicherung der MCP-Blockchain bei. Dafür erhalten sie Mining-Belohnungen und Transaktionsgebühren. Miner haben zudem das Recht, am Konsensprozess teilzunehmen und über Netzwerkvorschläge abzustimmen.

2. Benutzer: Benutzer zahlen CCN-Token, um auf die Rechenressourcen des Netzwerks zuzugreifen. Sie haben das Recht, die Ressourcen des Netzwerks zu nutzen und für ihre Rechenaufgaben genaue und zuverlässige Ergebnisse zu erhalten.

3. Entwickler: Entwickler erstellen Anwendungen und Dienste auf der Computecoin-Plattform. Sie haben das Recht, auf die Netzwerk-API zuzugreifen und deren Ressourcen für ihre Anwendungen zu nutzen.

4. Token-Inhaber: Token-Inhaber haben das Recht, über Netzwerkvorschläge abzustimmen und an der Governance des Netzwerks teilzunehmen. Sie haben außerdem das Recht, ihre Token durch Staking für zusätzliche Belohnungen einzusetzen.

5. Stiftung: Die Computecoin Network Foundation ist für die langfristige Entwicklung und Governance des Netzwerks verantwortlich. Sie hat das Recht, Mittel für Forschung und Entwicklung, Marketing sowie Community-Initiativen bereitzustellen.

Die Rechte und Pflichten jeder Interessengruppe sind darauf ausgelegt, sicherzustellen, dass das Netzwerk dezentralisiert, sicher und vorteilhaft für alle Teilnehmer bleibt.

Governance-Struktur: Dieses Multi-Stakeholder-Governance-Modell schafft ein ausgewogenes Ökosystem, in dem keine einzelne Gruppe die Entscheidungsfindung dominieren kann, und gewährleistet, dass das Netzwerk mit seinen dezentralen Grundsätzen im Einklang bleibt.

C. Mint CCN tokens

CCN-Token werden durch einen Prozess namens Mining erzeugt. Beim Mining werden dem Netzwerk Rechenressourcen bereitgestellt und die MCP-Blockchain abgesichert.

Miner konkurrieren darum, komplexe mathematische Probleme zu lösen, was zur Validierung von Transaktionen und zur Erstellung neuer Blöcke in der Blockchain beiträgt. Der erste Miner, der ein Problem löst, wird mit einer bestimmten Anzahl von CCN-Token belohnt.

Die Mining-Belohnung verringert sich im Laufe der Zeit gemäß einem festgelegten Zeitplan. Dies dient dazu, die Inflationsrate der CCN-Token zu kontrollieren und sicherzustellen, dass das Gesamtangebot über einen Zeitraum von 100 Jahren 21 Milliarden erreicht.

Zusätzlich zu Blockbelohnungen erhalten Miner auch Transaktionsgebühren. Diese Gebühren werden von Nutzern gezahlt, um ihre Transaktionen in die Blockchain aufnehmen zu lassen.

Mining ist so konzipiert, dass es für jeden mit einem Computer und einer Internetverbindung zugänglich ist. Allerdings passt sich der Schwierigkeitsgrad der Mining-Probleme dynamisch an, um eine konstante Erstellungsrate neuer Blöcke zu gewährleisten, unabhängig von der gesamten Rechenleistung im Netzwerk.

Token-Verteilung: Der Mining-Mechanismus gewährleistet eine faire und dezentrale Verteilung der Tokens und sichert gleichzeitig das Netzwerk, wodurch eine symbiotische Beziehung zwischen Token-Verteilung und Netzwerksicherheit entsteht.

D. Token-Freigabeplan

Die Freigabe von CCN-Tokens erfolgt nach einem vorab festgelegten Zeitplan, der einen stetigen und vorhersehbaren Token-Zufluss auf den Markt gewährleisten soll.

Mining Rewards: Die Mining-Belohnungen beginnen bei 10.000 CCN pro Block und verringern sich alle 4 Jahre um 50%. Dies ähnelt dem Bitcoin-Halving-Mechanismus.

Team und Berater: Die für das Team und die Berater zugeteilten Token werden schrittweise über einen Zeitraum von 4 Jahren freigegeben, wobei 25% nach 1 Jahr freigegeben werden und die verbleibenden 75% monatlich über die nächsten 3 Jahre verteilt werden.

Stiftung: Die für die Stiftung zugeteilten Token werden schrittweise über einen Zeitraum von 10 Jahren freigegeben, wobei jährlich 10% freigegeben werden.

4. Strategic partners: Für strategische Partner unterliegen die zugeteilten Token Vesting-Regelungen, die je nach Vereinbarung variieren, in der Regel jedoch zwischen 1 und 3 Jahren liegen.

5. Public sale: Im öffentlichen Verkauf erworbene Token werden sofort ohne Vesting-Periode freigegeben.

Dieser Ausgabeplan soll verhindern, dass große Token-Mengen plötzlich auf den Markt gelangen und Preisschwankungen verursachen. Gleichzeitig stellt er sicher, dass alle Beteiligten langfristige Anreize haben, zum Erfolg des Netzwerks beizutragen.

Marktstabilität: Der sorgfältig gestaltete Ausgabezeitplan verhindert Token-Dumping und gewährleistet langfristige Interessengleichheit aller Beteiligten, wodurch stabile wirtschaftliche Rahmenbedingungen für Netzwerkwachstum geschaffen werden.

E. Mining Pass and staking

Mining Pass ist ein Mechanismus, der es Nutzern ermöglicht, am Mining-Prozess teilzunehmen, ohne in teure Hardware investieren zu müssen. Nutzer können einen Mining Pass mit CCN-Tokens erwerben, der ihnen das Recht einräumt, einen Teil der Mining-Belohnungen zu erhalten.

Mining Passes sind in verschiedenen Stufen erhältlich, wobei höherwertige Pässe einen größeren Anteil an den Mining-Belohnungen bieten. Der Preis der Mining Passes wird vom Markt bestimmt und passt sich dynamisch nach der Nachfrage an.

Staking ist eine weitere Möglichkeit für Nutzer, Belohnungen zu verdienen. Nutzer können ihre CCN-Tokens durch Festlegung in einem Smart Contract für einen bestimmten Zeitraum sperren. Im Gegenzug erhalten sie einen Teil der Transaktionsgebühren und Blockbelohnungen.

Die Höhe der Belohnungen, die ein Benutzer durch Staking erhält, hängt von der Anzahl der gestakten Token und der Dauer der Festlegung ab. Benutzer, die mehr Token über längere Zeiträume staken, erhalten höhere Belohnungen.

Staking trägt zur Netzwerksicherheit bei, indem es die Anzahl der handelbaren Token reduziert, was das Netzwerk widerstandsfähiger gegen Angriffe macht. Es ermöglicht Benutzern außerdem, passives Einkommen mit ihren CCN-Token zu erzielen.

Zugänglichkeit der Teilnahme: Mining-Pass und Staking-Mechanismen demokratisieren die Netzwerkteilnahme und ermöglichen Nutzern mit unterschiedlichem technischem Fachwissen und Kapital, zum Wachstum des Netzwerks beizutragen und davon zu profitieren.

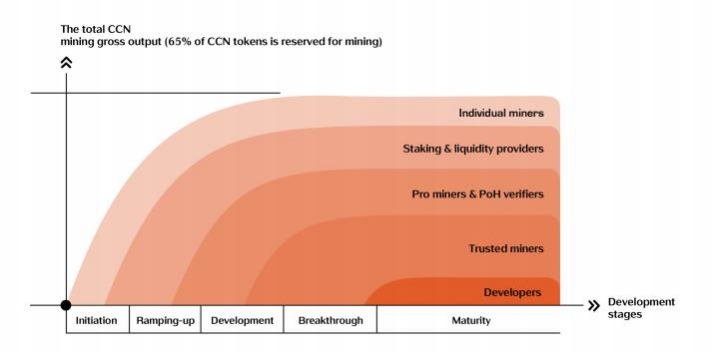

F. Entwicklungsphase

Die Entwicklung des Computecoin-Netzwerks ist in mehrere Phasen unterteilt:

1. Stage 1 (Foundation): In dieser Phase liegt der Schwerpunkt auf der Entwicklung der Kerninfrastruktur des Netzwerks, einschließlich der PEKKA-Schicht und der MCP-Blockchain. Zudem wird ein kleines Testnetzwerk mit einer begrenzten Anzahl von Knoten aufgebaut.

2. Stage 2 (Expansion): In dieser Phase wird das Netzwerk erweitert, um mehr Knoten einzubeziehen und mehr Arten von Rechenaufgaben zu unterstützen. Die KI-gestützten Selbstevolutionfähigkeiten werden ebenfalls in dieser Phase eingeführt.

3. Stage 3 (Maturity): Diese Phase konzentriert sich auf die Optimierung des Netzwerks und dessen Skalierung, um den hohen Anforderungen von Metaverse-Anwendungen gerecht zu werden. Sie beinhaltet auch die Integration des Netzwerks mit anderen Blockchain-Netzwerken und Metaverse-Plattformen.

4. Stage 4 (Autonomy): In der letzten Phase wird das Netzwerk vollständig autonom, wobei die KI-Agenten den Großteil der Entscheidungen über Netzwerkbetrieb und -entwicklung treffen. Die Rolle der Stiftung reduziert sich auf die Bereitstellung von Aufsicht und die Sicherstellung, dass das Netzwerk seiner ursprünglichen Vision treu bleibt.

Jede Phase wird voraussichtlich etwa 2-3 Jahre zur Fertigstellung benötigen, wobei während des gesamten Entwicklungsprozesses regelmäßige Updates und Verbesserungen veröffentlicht werden.

Roadmap-Strategie: Der phasenweise Entwicklungsansatz gewährleistet systematischen Fortschritt von der grundlegenden Infrastruktur bis zur Vollautonomie und verbindet schnelle Iteration mit langfristiger Vision und Stabilität.

VI. VERÖFFENTLICHUNGEN

Die folgenden Publikationen enthalten zusätzliche Details zum Computecoin-Netzwerk und seinen zugrundeliegenden Technologien:

1. "Computecoin Network: A Decentralized Infrastructure for the Metaverse" - Dieses Papier bietet einen Überblick über das Computecoin-Netzwerk, einschließlich seiner Architektur, des Konsensalgorithmus und der Tokenomics.

2. "Proof of Honesty: A Novel Consensus Algorithm for Decentralized Computing" - Dieses Papier beschreibt den Proof of Honesty-Konsensalgorithmus im Detail, einschließlich seines Designs, seiner Implementierung und seiner Sicherheitseigenschaften.

3. "PEKKA: A Parallel Edge Computing and Knowledge Aggregator for the Metaverse" - Dieser Artikel konzentriert sich auf die PEKKA-Ebene des Computecoin-Netzwerks, einschließlich ihrer Ressourcenaggregationsfähigkeiten und Berechnungsauslagerungsmechanismen.

4. "AI-Powered Self-Evolution in Decentralized Networks" - Dieser Artikel erörtert die Rolle der KI, die es dem Computecoin-Netzwerk ermöglicht, sich kontinuierlich zu verbessern und an wechselnde Bedingungen anzupassen.

5. "Tokenomics of Computecoin: Incentivizing a Decentralized Computing Ecosystem" - Dieser Artikel bietet eine detaillierte Analyse der CCN-Token-Ökonomie, einschließlich Token-Zuteilung, Mining, Staking und Governance.

Diese Veröffentlichungen sind auf der Website des Computecoin-Netzwerks sowie in verschiedenen akademischen Zeitschriften und Konferenzen verfügbar.

Akademische Grundlage: Die peer-reviewten Veröffentlichungen verleihen den Innovationen des Computecoin-Netzwerks akademische Glaubwürdigkeit und technische Validierung und überbrücken die Lücke zwischen theoretischer Forschung und praktischer Umsetzung.

VII. FAZIT

Das Metaverse stellt die nächste Evolutionsstufe des Internets dar und verspricht, unsere Online-Interaktionen, Arbeit und Unterhaltung zu revolutionieren. Allerdings wird die Entwicklung des Metaverse derzeit durch die zentralisierte Infrastruktur eingeschränkt, die das heutige Internet antreibt.

Das Computecoin-Netzwerk wurde entwickelt, um diese Einschränkung durch die Bereitstellung einer dezentralen, leistungsstarken Infrastruktur für das Metaverse zu adressieren. Unsere Lösung nutzt die Kraft dezentraler Clouds und Blockchain-Technologie, um eine zugänglichere, skalierbarere und kosteneffizientere Plattform für Metaverse-Anwendungen zu schaffen.

Die zweischichtige Architektur des Computecoin-Netzwerks – PEKKA und MCP – bietet eine umfassende Lösung für den Metaverse. PEKKA übernimmt die Aggregation und Planung von Rechenressourcen, während MCP die Sicherheit und Authentizität von Berechnungen durch seinen innovativen Proof of Honesty-Konsensalgorithmus gewährleistet.

Die KI-gestützte Selbstevolutionfähigkeit des Netzwerks stellt sicher, dass es sich kontinuierlich verbessern und an wechselnde Bedingungen anpassen kann, wodurch es an der Spitze der Technologie bleibt.

Die Tokenomics von CCN sind darauf ausgelegt, ein ausgewogenes und nachhaltiges Ökosystem zu schaffen, das alle Stakeholder dazu anregt, zum Erfolg des Netzwerks beizutragen.

Strategische Perspektive: Die erfolgreiche Implementierung des Computecoin Network könnte die Einführung des Metaversums erheblich beschleunigen, indem grundlegende Infrastrukturprobleme gelöst werden, die Skalierbarkeit und Zugänglichkeit bisher einschränkten.

Wir sind überzeugt, dass das Computecoin-Netzwerk das Potenzial hat, zur grundlegenden Infrastruktur für das Metaversum zu werden und eine neue Generation dezentraler Anwendungen und Erlebnisse zu ermöglichen. Mit der Unterstützung unserer Community sind wir bestrebt, diese Vision zu verwirklichen.

Vision Realization: Computecoin stellt nicht nur eine technologische Lösung dar, sondern einen Paradigmenwechsel im Aufbau und Betrieb von Recheninfrastruktur, der die digitale Landschaft für die kommenden Jahrzehnte potenziell neu gestalten könnte.

REFERENCES

1. Stephenson, N. (1992). Snow Crash. Bantam Books.

2. Nakamoto, S. (2008). Bitcoin: A Peer-to-Peer Electronic Cash System.

3. Buterin, V. (2014). Ethereum: A Next-Generation Smart Contract and Decentralized Application Platform.

4. Benet, J. (2014). IPFS - Inhaltsadressiertes, versioniertes P2P-Dateisystem.

5. Filecoin Foundation. (2020). Filecoin: A Decentralized Storage Network.

6. Crust Network. (2021). Crust: Dezentrales Cloud-Speicherprotokoll.

7. Wang, X., et al. (2021). Dezentrales Cloud Computing: Ein Überblick. IEEE Transactions on Parallel and Distributed Systems.

8. Zhang, Y., et al. (2022). Blockchain für das Metaverse: Ein Überblick. ACM Computing Surveys.

9. Li, J., et al. (2022). KI-gestützte Blockchain: Ein neues Paradigma für dezentrale Intelligenz. Neural Computing and Applications.

10. Chen, H., et al. (2021). Tokenomics: Ein Überblick über die Ökonomie von Blockchain-Token. Journal of Financial Data Science.